我们所面临的可能是一个极其棘手的问题,虽然解决这一问题的时间尚不可知,但是整个人类的未来可能都取决于此。 —— Nick Bostrom

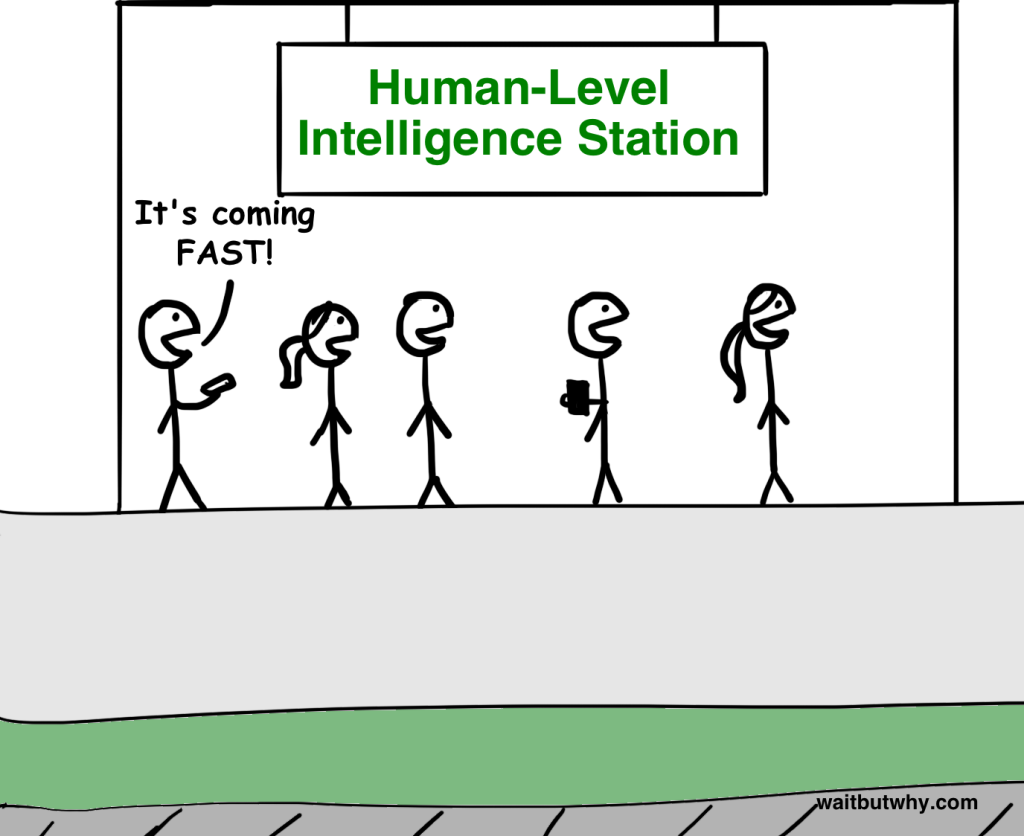

此前的文章介绍了什么是狭义人工智能(ANI),这是一种专门从事特定任务的人工智能,比如计算行车路线或下棋,这一类型的人工智能如今已随处可见。也探讨了为什么从狭义人工智能到通用人工智能(AGI)是一个巨大的挑战,以及为什么凭借指数级增长的技术使得 AGI 可能得以实现并显得不那么遥不可及。机器一旦达到了人类水平,就有可能会出现以下场景:

这不禁使我们陷入沉思:面对将来,甚至在我们有生之年就有可能出现的“超级人工智能(ASI,比任何人类都聪明的人工智能)”,我们甚至都不知道用怎样的心情去面对它。

在深入研究之前,我们首先需要提醒一下自己,机器拥有超级智能究竟意味着什么?

关键的区别在于:是速度上还是质量上的超级智能。大多数时候,当人们想象一台超级智能计算机时,首先想到的是它是否会与人类一样聪明,思考速度远超人类。即使这台机器的思考方式与人类一样,但速度比人类快一百万倍,这也意味着它只需五分钟的时间就可以完成人类可能需要十年才可以解决的事情。

这一点令人印象深刻,ASI 的思考速度比人类快很多,但真正的区别在于 ASI 在智能质量上的优势,这两者存在本质区别。人类之所以比黑猩猩更聪明,并不在于人类拥有更快的思考速度,而是因为人类的大脑中包含了许多复杂的认知功能模块,这些模块使人类能够实现复杂的语言表述、长期规划和抽象推理等功能,但黑猩猩的大脑并没有这些模块。即使将黑猩猩大脑的思考速度提升数千倍,它也无法达到人类的大脑水平,换言之,即使花费十年的时间,黑猩猩也想象不出人类究竟是如何使用一套定制化的工具来组装一个复杂模型的,但人类只需几个小时就能完成。以人类的认知来看,无论给予黑猩猩多少时间,它都无法达到与人类相似的水平。

黑猩猩能够理解人类是什么、摩天大楼是什么,但它永远都无法理解摩天大楼是如何被人类建造出来的。在黑猩猩的世界观里,任何巨大的事物都被视为自然的一部分,它不仅不会建造摩天大楼,也无法想象人类是如何建造出摩天大楼的。微小的智能差异可能会导致个体对世界本质形成根本性的误解。

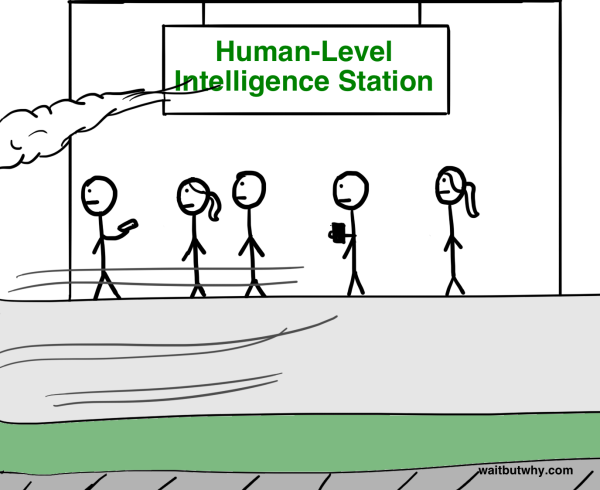

就我们今天所讨论的智力范围内,甚至就生物之间更小的范围而言,黑猩猩与人类之间的智力质量差异微乎其微。在之前的一篇文章中,曾用楼梯作为类比,以形容生物认知能力的范围:

想要了解一台具有超级智能的机器究竟有多厉害?想象一下,在上图楼梯的深绿色台阶上有着一台超级智能机器,虽然它的位置只比人类高两层且只具备少量的超级智能,但人类与这台机器在认知上的差距就像先前描述的黑猩猩与人类的差距一样大。这台机器能够执行的任务对人类而言就好像黑猩猩无法理解人类建造摩天大楼一样,超出了人类的理解能力,而这仅仅是一台只比我们高两个台阶的智能机器。 就像人类对待蚂蚁一样,即使这台机器愿意花数年的时间向我们传授它所知道最简单的知识,人类依旧难以理解。

但我们今天所讨论的超级智能远超这个台阶上的任何事物。一旦智能技术得到爆炸式增长,机器就会变得愈加聪明,它能够更快地提升自己的智能,并迅猛地提高楼梯的层级。一开始,机器要想从黑猩猩的位置上升一层可能需要数年的时间,但当它比人类高出两个层级时,机器也许只要几个小时就能跃升至下一个层级,当它比人类高出十层台阶时,它能以每秒四层台阶的速度往上升。这就是为什么我们需要意识到,当新闻里第一次报道出现了一台具备人类智能水平的机器后,我们可能很快就会面临与一个比人类更高智能(甚至高至上百万)体共存的现实:

如果我们确定仅是理解一个只比我们高出两层台阶的机器就是一项不可能的任务,那么我们就要明白:我们无法知道人工智能会做什么,也没有办法会给我们带来什么后果。任何假装知道的人其实都不明白超级智能究竟是什么。

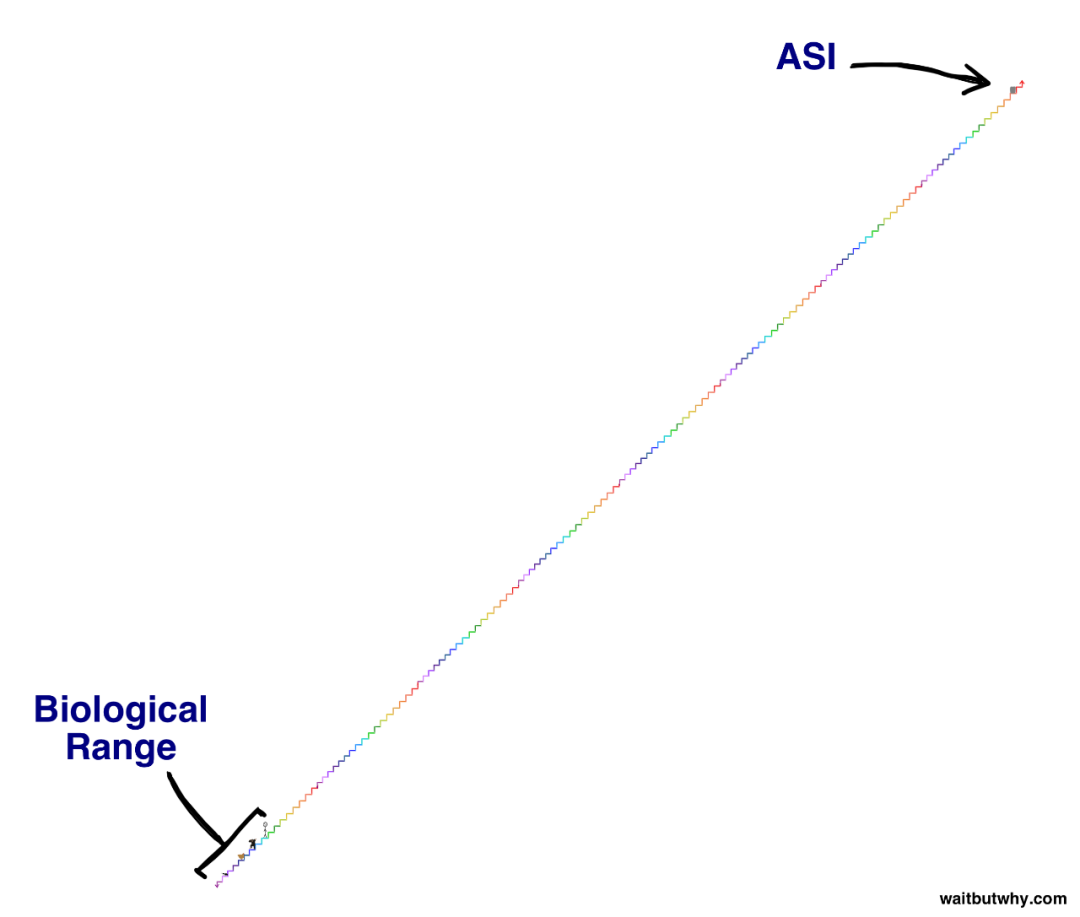

生物大脑的发展经历了数亿年时间,进化是缓慢而渐进的,从这个意义上来说,如果人类能够创造出一台 ASI 机器,那么势必会对生物的进化带来巨大的冲击。当然或许这本身就是进化的一部分,也许进化的本质就应该是智力越来越高,直至有一天有一个智能体创造出了超级智能,达到这个水平就像一个绊线(tripwire),将改变整个世界的生物生存法则:

一部分科学家认为问题不在于人类是否会触发那根绊线,而是何时会触发(这是一个相当疯狂的观点)。

那我们究竟该怎么办?

世界上没有任何人能够准确预测出触发那根绊线后会发生什么。牛津大学的哲学家、首席人工智能思想家 Nick Bostrom 认为,我们可以将所有潜在的结果归纳为两大类:

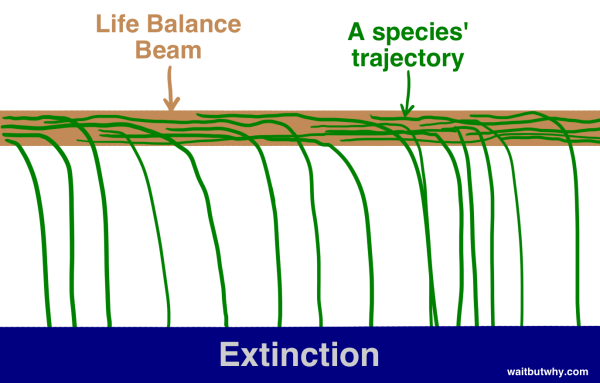

首先,纵观历史,我们发现生命是这样运作的:某一物种突然出现,存在一段时间,随后在一段时间后不可避免地从“生命的平衡木”上跌落,最终走向灭绝:

“所有物种最终都会灭绝”这一规律在历史上几乎和“所有人最终都会死亡”一样是一个亘古不变的法则。迄今为止,已有 99.9% 的物种从“生命的平衡木”上掉了下来,并且似乎很明显,如果某一物种在平衡木上一直处于摇摆状态,那么迟早会被其他物种、自然界的一阵狂风或突然降落的一颗小行星给撞下来。Bostrom 将物种灭绝称为一种“吸引子状态”,所有物种都岌岌可危,没有任何一种物种可以在平衡木上掉落后再返回。

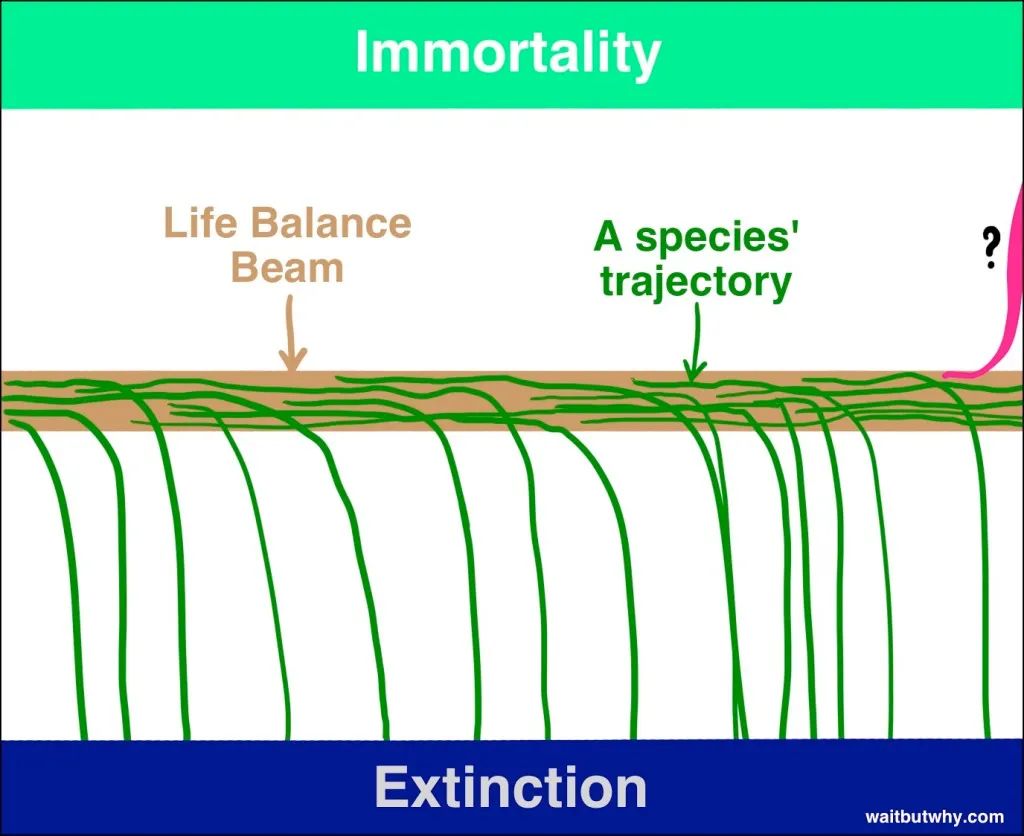

虽然大多数科学家都认为 ASI 有能力将人类推向灭绝,但同时许多人也相信,如果运用得当,ASI 可以帮助人类及其他物种物种迈向另一个吸引子状态 —— 物种永生。Bostrom 认为,物种的永生和灭绝都是一种吸引子状态,也就是说,如果我们设法达到了这一状态,人类及其他物种便迈向了另一个吸引子状态 —— 物种永生。Bostrom 认为,物种的永生和灭绝都是一种吸引子状态,也就是说,如果我们设法达到了这一状态,我们将永远不再面临灭绝的影响 —— 我们将战胜死亡,获得永生。因此,尽管目前为止,绝大多数物种都从平衡木上掉下去灭绝了,但 Bostrom 认为平衡木具有两面性,只是迄今为止地球上的生命还没有聪明到发现如何走向平衡木的另一端。

如果 Bostrom 等其他人的观点是正确的,那么我们就需要接受两个截然不同的观点:

- ASI 的出现将首次使得一种物种有可能摆脱灭绝的命运,并实现永生。

- ASI 的出现将产生难以想象的影响,也很有可能使人类从平衡木上掉落下来,使人类灭绝。

很有可能,一旦人类在进化的过程中碰触了绊脚线,它将永远地终结人类与生命平衡木的关系,并创造出一个全新的世界,不管这时的人类存在与否。

目前,人类似乎唯一需要关心的问题是:我们何时会触发那根绊脚线,并且当我们从平衡木上掉落下来后会进入哪种吸引子状态。

没有人能够知道上述问题的答案,但许多非常聪明的人已经花费了数十年的时间来思考这些问题。接下来,我们将深入探讨他们所提出的观点和想法。

让我们从问题的第一部分入手:我们何时会踩到绊线?

即,第一台机器达到超级智能还需要多久?

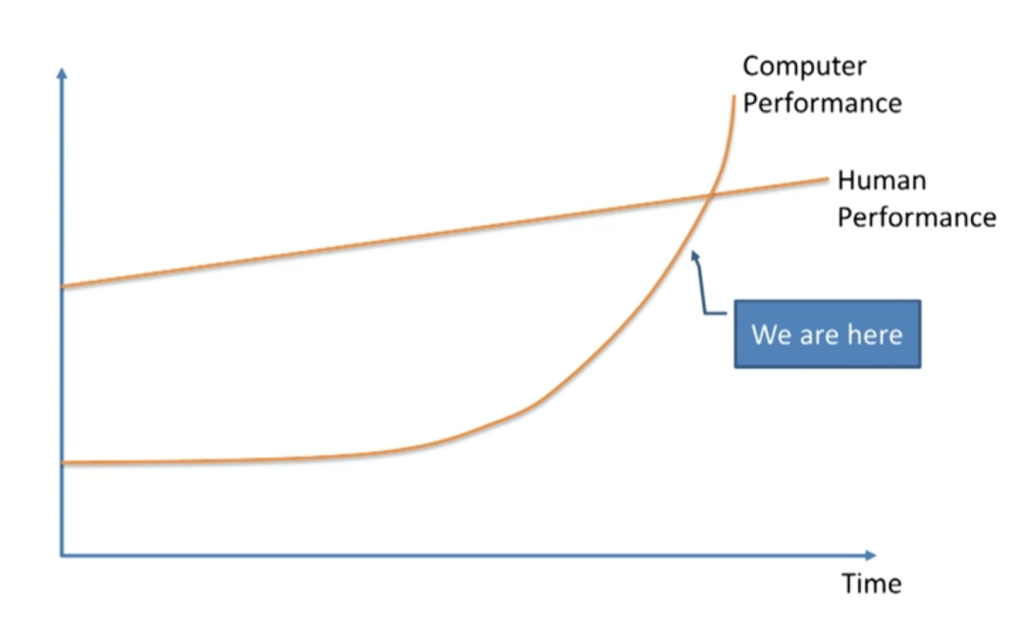

不出所料,科学家与思想家对这一问题的分歧很大,并展开了激烈的讨论,包括 Vernor Vinge 教授、科学家 Ben Goertzel、Sun Microsystems 的联合创始人 Bill Joy,以及著名的发明家和未来学家 Ray Kurzweil 在内的许多人都同意机器学习专家 Jeremy Howard 在 TED 演讲时用到的这张图:

这些人相信 ASI 很快就会发生 —— 尽管目前机器学习的发展很缓慢,但这一领域正经历着指数级增长的趋势,相信在未来几十年内,它将直接超越我们。

另一些人,如微软联合创始人 Paul Allen、研究心理学家 Gary Marcus、纽约大学计算机科学家 Ernest Davis 以及科技企业家 Mitch Kapor 则认为,像 Kurzweil 这样的思想家严重低估了这一挑战难度,并认为我们离绊脚线还有很长一段的路要走。

支持 Kurzweil 观点的人反驳说,唯一低估的是指数级增长的潜力。他们将质疑者比作那些在 1985 年看着互联网这棵幼苗缓慢生长的人,这些人当时认为互联网在不久的将来不可能产生任何影响。

持有怀疑态度的人可能会反驳说,在实现智能的过程中,每一步所需的进步都是指数级的,这将导致技术进步的指数增长特性被抵消等诸如此类的观点。

Nick Bostrom 属于第三方阵营,这一阵营的人认为以上两个阵营的人都没有充足的理由确定时间线,并承认:1.这绝对不可能会在不久的将来发生;2.这一点并不能保证,它可能需要更长的时间。

还有一些人,比如哲学家 Hubert Dreyfus,他们认为以上三个阵营的人都太过天真,竟然相信会有一根绊脚线,他们认为 ASI 无法实现的可能性更高一些。

那么,当你把以上所有这些观点都综合在一起时,你会得到什么结论呢?

Vincent C. Müller 和 Nick Bostrom 在 2013 年进行了一项研究调查,在各个会议上向数百名人工智能专家提出了以下问题:“假设人类能够在没有重大负面干扰的情况下持续进行科学活动,你认为在哪一年会可能(10% / 50% / 90%)出现超越人类水平的人工智能?”他们要求专家提供三个时间:乐观(认为有 10% 的可能在这一年达成)、中性(认为有 50% 的可能在这一年达成)和悲观(认为有 90% 的可能在这一年达成)。结果如下:

- 乐观估计的年份是 2022 年。

- 中性预计的年份是 2040 年。

- 悲观估计的年份是 2075 年。

绝大多数的参与者认为,在 25 年以后,人类将实现 AGI。2075 年是一个相对悲观的预计,这说明如果你现在是一名青少年,那么有一半以上的人工智能专家认为在你的有生之年有 90% 的可能性会见证 AGI 的出现。

最近,作者 James Barrat 在 Ben Goertzel 的年度 AGI 大会上进行了一项独立研究,他简单地询问参与者 AGI 将在以下哪个年份出现 —— 2030 年、 2050 年、2100 年,或者永远都不会实现。结果显示:

- 认为 AGI 会在 2030 年之前出现的占:42%。

- 认为 AGI 会在 2050 年之前出现的占:25%。

- 认为 AGI 会在 2100 年之前出现的占:10%。

- 认为永远都不会实现的占:2%。

这一结果与 Müller 和 Bostrom 的结果非常相似,在 Barrat 的调查中,有超过三分之二的参与者认为 AGI 将在 2050 年问世,有近一半的人认为 AGI 将在未来 15 年内实现。同样需要注意的是,只有 2% 的受访者认为 AGI 永远不会出现。

但事实上 AGI 并不是绊脚线,ASI 才是。 那么专家们认为人类何时才能实现 ASI 呢?

Müller 和 Bostrom 还针对这一问题对专家们进行了提问,选项有:A)实现 AGI 后的两年内达到 ASI;B)实现 AGI 后的 30 年内达到 ASI。结果如下:

中位数显示,认为在两年时间内能够完成 AGI 到 ASI 转变的可能性只有 10%,在 30 年内能够达成的可能性达 75%。

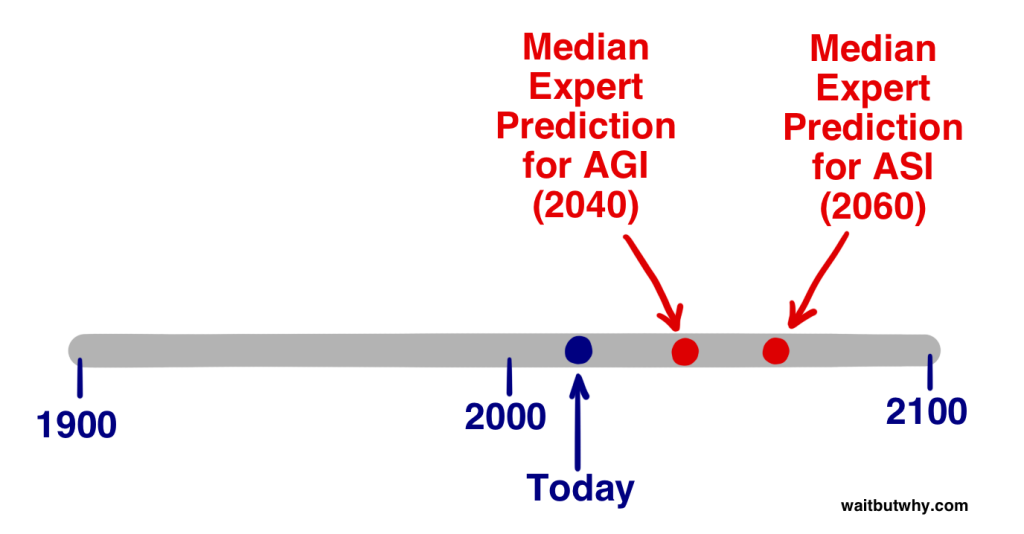

通过以上数据,我们可以得知大部分专家认为 AGI 到 ASI 的转变可能需要花费 20 年的时间。因此,在全球的人工智能专家中,中位数的专家估计人类会在 2040 年实现 AGI,并在 20 年后(2060 年)实现 ASI —— 踩上那根绊线。

当然以上所有的统计数据都是推测,它们只代表了人工智能专家群体的大多数意见,但这同时也表明,大部分对这一领域十分了解的人都认为 2060 年会是 ASI 到来的一个合理的年份,距离现在只剩 45 年。(本文写于2015年)

现在让我们来看下上面问题的第二个部分:当我们踩到这根绊线时,我们会掉到平衡木的哪一边?

超级智能将带来巨大的力量,而对于我们来说,关键的问题是:

谁将掌控这股力量,他们的动机是什么?

这个问题的答案将决定 ASI 究竟是一项伟大的、难以置信的发明,还是一项无比可怕的发明,亦或是介于两者之间。

同样地,专家们对这一问题的答案也各不相同,并且再次展开了激烈的讨论。Müller 和 Bostrom 在对专家就 AGI 可能会对人类产生何种影响提问,结果显示,52% 认为结果会是好或非常好;31% 认为影响是糟糕或非常糟糕,只有 17% 的人认为结果不好不坏。换而言之,这一领域的专家普遍认为 AGI 对人类产生的影响会很大,无论是好是坏。需要注意的是,这一问题是关于 AGI 的 —— 如果问的是 ASI,认为不好不坏的人可能会低于 17%。

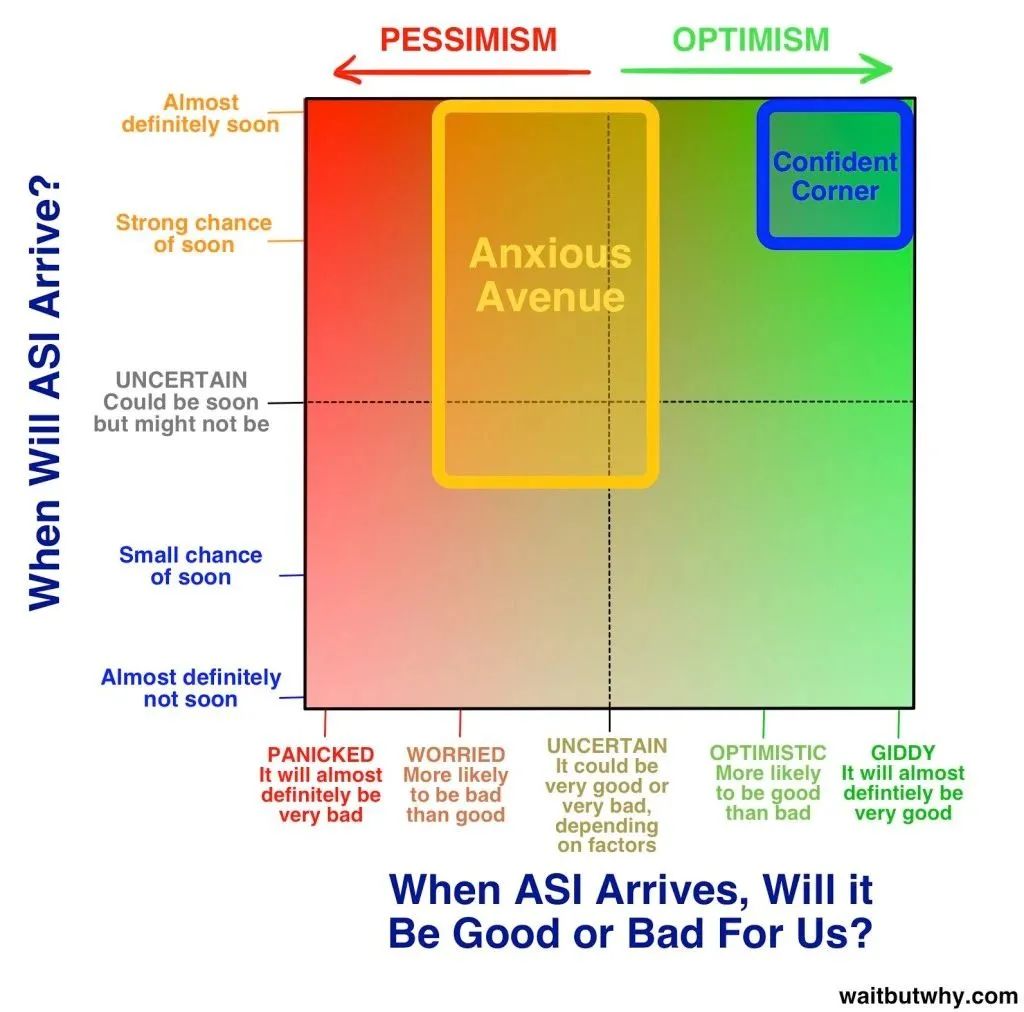

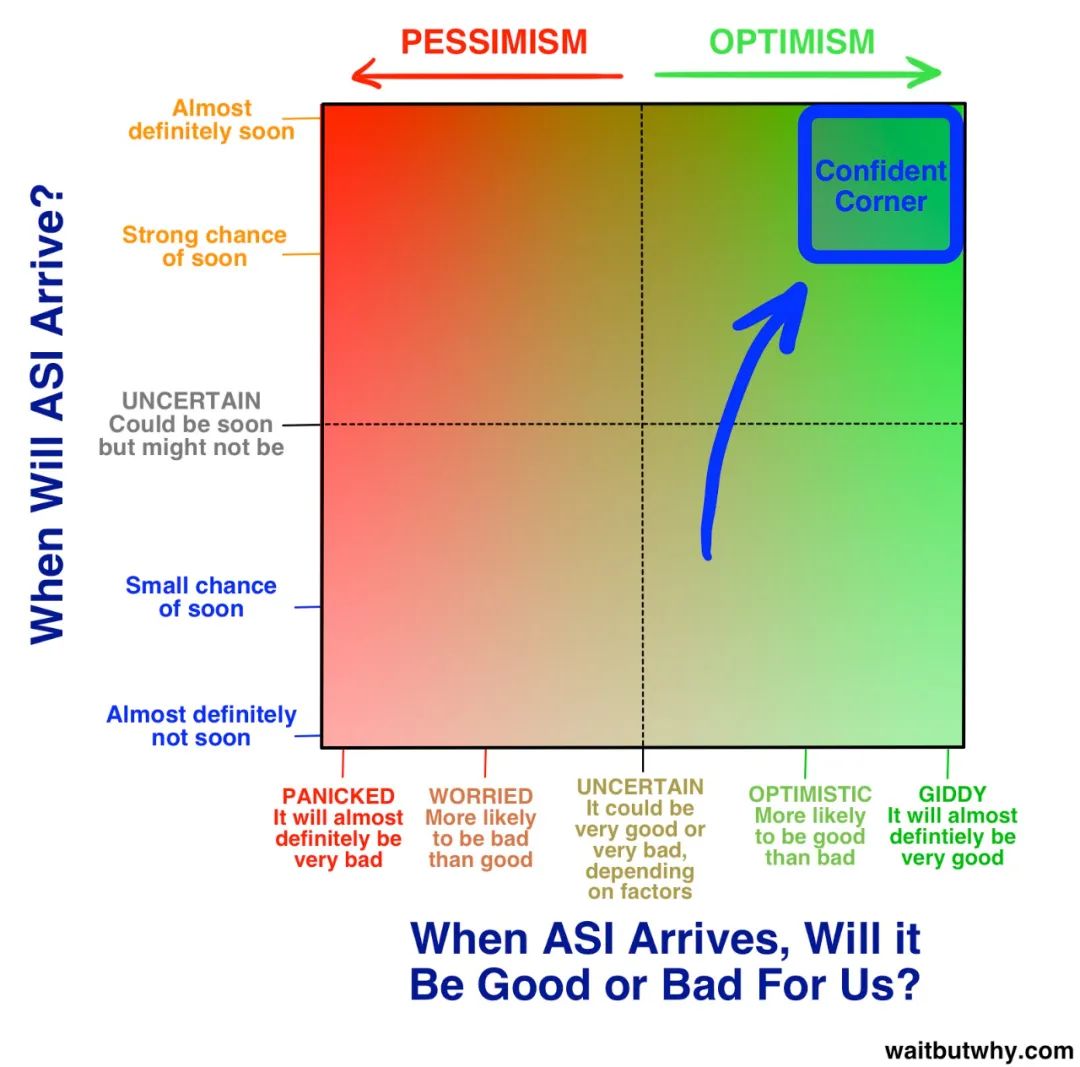

在我们深入讨论这个问题好坏之前,让我们先把“何时会发生?”和“结果是好是坏?”的结果结合起来制成下图,这代表了大多数专家的观点:

我们稍后会详细讨论主流阵营的观点,但首先,我们先来问下自己是怎么想的,其实也大概能够猜到大多数人是怎么想,因为这是由于人类的思维习惯造成的。大多数人之所以没有真正考虑过这一问题,主要有以下几点原因:

- 正如第一部分所提,电影呈现了许多科幻的人工智能场景,使我们觉得人工智能并不是一个值得认真对待的课题,并造成了很多困扰。James Barrat 认为这种情况就好比美国疾病控制中心发布吸血鬼警报一样滑稽。

- 人类往往需要看到实际证据才会相信某一件事情是真实的。就像 1988 年的计算机科学家们已经常在讨论互联网可能会变得多么重要一样,但当时的普通人并不会认为互联网会改变他们的生活,直至他们的生活真的被改变了。这在一定程度上是因为 1988 年的计算机还具备如今的能力,所以那时的人们看着电脑会想:“这怎么可能是会一个改变生活的东西?”那时人们的想象力受限于个人计算机的能力,他们很难想象计算机未来可能的形态。 现在同样的情况也发生在人工智能领域。我们听到很多人说人工智能将会造成很大影响,但因为这个事情还没有发生,并且由于我们对弱人工智能的一些经验,我们很难相信人工智能真的能改变我们的生活。而这些偏见正是人工智能专家们在试图引起我们注意时所面临的挑战,尤其是当我们每天都还沉浸在自我琐碎的事务中时。

- 即使你愿意相信人工智能会带来很大的影响,但今天又有多少次想过“未来人类实现永生后,你可能并不存在了”这样的可能性呢?即使这个问题比你今天做的任何事情都重要得多?这是因为我们的大脑总是习惯于关注日常的小事,而忽略了长期会发生更重要的事。人类的天性就是这样。

这两篇文章的目标之一是将读者从“我喜欢考虑的其他事”阵营转到“专家阵营”,即使最后只是站在上图两条不确定线的交点上,但目标也达到了。

在此前的研究中,大多数的观点都属于所说的“主流阵营”,尤其是有超过四分之三的专家都属于主流阵营中的两个子阵营:

为什么 ASI 会在未来产生积极影响

我们将对这两个子阵营进行深入讨论。首先,让我们先从有趣的那一方开始吧 —— 为什么 ASI 会在未来产生积极影响。

在了解人工智能的过程中,发现有许多人站在“信心角”:

站在“信心角”的人非常兴奋,他们认为 ASI 会引领人类走向生命平衡木有趣的一侧,他们对未来充满期待,并且只需耐心等待。

这一部分的人与稍后将讨论的其他思想家的不同之处在于他们愿意相信 ASI 会引领人类走向生命平衡木有趣的一侧。

这种信心从何而来有待商榷。批评者认为,这些人过于兴奋,以至于他们忽视了潜在的风险。“信心角”的人认为,总体而言,技术对人类的帮助远大于其造成的伤害,因此幻想末日场景未免太过于天真。

以上两方的观点我们都会进行讨论,以便形成自己的观点。但在开始下面这一章节前,请暂时把质疑搁置一边,让我们看看平衡木的两侧究竟是什么,并试着接受事情真有可能会发生。如果我们向一个狩猎采集者展示我们现在舒适的家园、高科技和富饶的文明世界,他会觉得这一切都是魔法。

Nick Bostrom 描述了超级人工智能的三种工作模式:

- 先知模式:能够准确回答几乎所有的问题,包括人类难以轻松回答的复杂问题,比如:我该怎样制造出一台更高效的汽车发动机?Google 便是一种原始的先知模式。

- 精灵模式:能够执行任何高级指令 —— 如用分子装配器(molecular assembler)制造一个更高效的汽车发动机。

- 主权模式:被赋予广泛和开放追求的实体,可以自由活动,自行决定最佳操作方式 —— 如发明一种比汽车更快、更便宜和更安全的出行方式。

这些问题和任务对我们来说似乎很复杂,但对一个超级智能系统来说,可能就像“我的笔掉了,你能帮我捡一下吗?”那样简单。

上图中 “焦虑大道 “阵营的 Eliezer Yudkowsky 是这么说的:

自信角阵营有着很多渴望成功的科学家、发明家和企业家,但如果要想探索人工智能最为积极的一面,我们只需要一个人作为我们的导游。

Ray Kurzweil 是一个颇具争议的人物。经研究发现,有的人对其观点极力推崇,将其视为神明一般;有的人则对其颇为不屑,嗤之以鼻。还有一些人则持中立态度,比如作家 Douglas Hofstadter 在讨论 Kurzweil 的著作时说过一句生动的话:“就好像把美食和狗屎混合在一起,这样你就不可能分辨出什么是好坏了。”

无论你是否喜欢 Kurzweil 的观点,所有人都认为他是一个令人印象深刻的人物。他在十几岁时就开始发明东西,并做出了一些突破性的发明,包括第一台平板扫描仪、第一台能把文字转化为语言的扫描仪(可供盲人使用)、著名的 Kurzweil 音乐合成器(第一台真正意义上的电子琴),以及第一套商业销售的语音识别系统。Kurzweil 是五本畅销书的作者,他以大胆预测而闻名,并且准确率一直很高,比如在 80 年代末期,他就预测互联网将在 21 世纪初成为全球级现象。他被《华尔街日报》称为“不安分的天才”、被《福布斯》称为“终极思想机器”、被《Inc.》称为“爱迪生的真正传人”、被比尔盖茨称为“我认识的最擅长预测人工智能未来的人”。2012 年,Google 联合创始人 Larry Page 曾邀请 Kurzweil 担任 Google 的工程总监,2011 年,他共同创办了现由 NASA 运营和Google 赞助的奇点大学(Singularity University)。他的一生成就非凡。

他的经历十分重要。当 Kurzweil 阐述他对未来的愿景时,他听起来完全像一个疯子,但事实上他并没有,相反他是一个极其聪明、博学、在世界上具有重要影响的人。你可能觉得他对未来的看法是错误的,但他并不是一个傻瓜。当你听到 Kurzweil 的预言时,你就不难理解他为什么会有如此多的热情追随者,他被称为奇点主义者。其他“信心角”的思想家如 Peter Diamandis 和 Ben Goertzel 也有同样的预言。以下是他认为可能会发生的事:

时间线

Kurzweil 认为计算机将在 2029 年实现 AGI,到了 2045 年,我们不但会拥有 ASI,还将迎来一个全新的世界 —— 奇点时代。尽管他的人工智能时间线曾被认为过于激进,即使是现在仍有许多人这样认为,但在过去 15 年里,人工智能快速发展的进度更接近 Kurzweil 的时间线。他的预测比 Müller and Bostrom 调查结果的中位数受访者(2040 年实现 AGI,2060 年实现 ASI)更大胆一些,但并没有早很多。

Kurzweil 对 2045 年奇点时代的描述是由生物技术、纳米技术和最强大的人工智能三场革命共同造成的。

在我们继续讨论人工智能之前,让我们先讨论以下部分内容,因为几乎每篇关于人工智能未来的文章都会涉及纳米技术,让我们首先讨论纳米技术。

纳米技术蓝盒

纳米技术是指操作介于 1-100 纳米之间物质的技术。一纳米是一米的十亿分之一,或是一毫米的百万分之一。1-100 纳米这一范围涵盖了病毒(直径 100 纳米)、DNA(10 纳米宽),大分子比如血红蛋白(5 纳米),中分子如葡萄糖(1 纳米)。一旦我们能够完全掌握纳米技术,下一步便是操作单个原子,原子仅比这小一个数量级(约 0.1 纳米)。

为了便于理解人类尝试操作这一范围内物质的挑战,让我们将同样的事物放大到更大的尺度来比较。国际空间站距离地球 268 英里(431 公里)。如果一个人的头能够伸到国际空间站,他将比普通人大 25 万倍。如果将 1-100 纳米放大 25 万倍,你就会得到 0.25-25 毫米的长度。因此,纳米技术就相当于一个身高有国际空间站那么高的巨人,用介于沙粒和眼球大小之间的材料精心构建复杂的物体。如果要想达到下一个水平 —— 操控单个原子 —— 这个巨人必须小心地放置 1/40 毫米大小的物体,普通人类则需要显微镜才能看到它们。

Richard Feynman 在 1959 年的一次演讲中首次提出了纳米技术,当时他解释道:“据我所知,物理学并不认为原子级别操纵物质是不可能的。从原理上来讲,物理学家能够制造出化学家写出来的任何物质…怎么做呢?只要把一个个原子放在化学家说的地方。”就是这么简单。如果你能清楚知道如何移动单个分子或原子,我们就可以制造出任何东西。

纳米技术于 1986 年首次成为一个正经学科,当时工程师 Eric Drexler 在他的开创性著作《创造引擎》(《Engines of Creation》)中奠定了纳米技术的基础。但 Drexler 建议那些想要了解纳米技术最现代理念的人最好阅读他在 2013 年出版的《Radical Abundance》一书。

灰色凝胶蓝盒

我们现在正处于一个分支中,而这个分支本身也是另一个分支。这非常有趣。

在这里有一个关于纳米技术不那么有趣的部分想要告诉你。在较早的纳米技术理论版本中,有一种纳米组装方法是创建数万亿个微小的纳米机器人,这些纳米机器人将协同工作以构建某些事物。制造数万亿个纳米机器人的一种方法是制造一个可以自我复制的纳米机器人,然后让繁殖过程把一个变成两个,两个变成四个,四个变成八个,只需一天的时间,就会有几万亿个纳米机器人准备就绪。这就是指数级增长的力量。

这个方法非常巧妙,但是一不小心就会引发全球末日。凭借指数级增长的力量,人们能够迅速制造出数万亿个纳米机器人,但这同时也是一个很可怕的地方。因为如果系统发生故障,纳米机器人并没有像预期那样在总数达到几万亿时停止复制,那该怎么办?纳米机器人被设计成消耗任何碳基材料,以满足复制过程,令人不快的是,所有生命都是碳基的。 地球上的生物大约含有 10^45 个碳原子。如果一个纳米机器人含有 10^6 个碳原子,那么只需 10^39 个纳米机器人就能吞噬地球上所有的生命,这将在第 130 次复制(2^130 约等于 10^39)后发生,场景就像一个纳米机器人海洋(即灰色的粘性物质)在地球上滚动一样。科学家认为,纳米机器人进行一次自我复制只需 100 秒,这意味着一个简单的错误就会在 3.5 小时内毁灭地球上的所有生命。

更糟糕的是,如果恐怖分子掌握了纳米机器人技术,并具备对其进行编程的知识,他就可以先制造出数万亿个纳米机器人,并对它们进行编程,让它们在几周内悄无声息地均匀分布在世界各地,不被察觉。然后他就可以同时发动袭击,只需 90 分钟的时间就能吞噬一切 —— 并且由于纳米机器人被分散在世界各地,人类没有办法可以阻挡它们。

虽然这一恐怖故事已经被广泛讨论多年,但好消息是它可能被夸大了。Eric Drexler 创造了“灰色泥浆”这一术语,他在阅读完这篇文章之后给作者发了一封电子邮件,表达了他对灰色泥浆场景的看法:“人们喜欢恐怖故事,而这个故事就像僵尸一样。想法本身就会吞噬大脑。”

一旦我们真正掌握纳米技术,我们就可以用它来制造技术设备、服装、食品和各种与生物有关的产品,比如人造红细胞、微小病毒或癌细胞破坏者、肌肉组织等。在一个使用纳米技术的世界里,材料的成本不再取决于它的稀缺程度或是制造流程的难度,而在于其原子结构的复杂程度。 在纳米技术的世界里,一颗钻石的价格可能比一块橡皮还便宜。

我们目前还没有达到这一阶段。目前我们还不清楚是低估或是高估了实现这一目标的难度,但这一阶段似乎离我们并不遥远。Kurzweil 预计我们将在 2020 年代实现这一目标。各国政府都知道纳米技术可能是一项颠覆世界的技术,并且已在纳米技术研究上投入了数十亿美元(美国、欧盟和日本迄今为止总共投入了 50 多亿美元)。

想象一下,一台超级智能计算机如果能够使用纳米级的装配器,其带来的可能性是难以置信的。纳米技术是我们发明的,我们即将征服它,但我们所做的事情在超级智能系统看来只是一个笑话,我们必须假设 ASI 能够创造出更强大、更先进的技术,发达到人类的大脑都没法理解。

在考虑到“人工智能革命对我们有利”的场景时,我们几乎不可能高估将要发生的事情。因此,以下关于人工智能未来的预测看起来有些夸张,但请记住,它们也可能以我们无法想象的方式实现。因为最有可能的是,我们的大脑根本没法预测将会发生什么。

*以上文章翻译自 Tim Urban 的《The AI Revolution: Our Immortality or Extinction》,如需原文,请与我们联系。

WF Research 是以第一性原理为基础的专业顾问服务机构,欢迎关注和留言!

微信号:Alexqjl