摘要

大语言模型(LLM)的出现引领了一种全新的搜索引擎范式,该范式使用生成模型来收集和总结信息,以回答用户的查询。我们已正式将这一新兴技术规范为生成引擎(Generative Engines)的统一框架,该技术具备生成准确且富有个性化回答的潜力,并有能力迅速替代 Google 和 Bing 等传统搜索引擎。生成引擎通常综合多个信息来源,并利用 LLM 进行总结,以满足用户的查询。虽然这种转变显著提升了用户有效性和生成引擎的流量,但也给第三方利益相关者 —— 网站和内容创作者带来了巨大的挑战。由于生成引擎的黑盒特性和快速变化的性质,内容创作者几乎无法掌控其内容何时以及如何展示。随着生成引擎的普及,有必要提供正确的工具,以确保创作者的经济收益不会有严重的负面影响。为了解决这一问题,我们提出了一个新的范式 —— 生成引擎优化(GEO)。该优化旨在通过黑盒优化框架,提高生成引擎响应中内容的可见性。我们定义了可见性指标,以帮助内容创作者。我们引入了 GEO-BENCH —— 一个涵盖多个领域的多样用户查询基准,以及回答这些查询所需的来源,从而促进了在这一新范式下的系统评估。通过严格的评估,我们发现 GEO 可以在生成引擎响应中将可见性提高 40%。此外,我们发现这些策略在不同领域之间的有效性存在差异,突显了为特定领域采用不同方法的重要性。我们的研究在信息发现系统领域开辟了新的方向,对生成引擎的开发者和内容创作者都具有深远的影响。

1 介绍

30 多年前,传统搜索引擎的发明标志着全球信息获取和传播方式的重大变革。尽管这些搜索引擎十分强大,为学术研究和电子商务等领域引入了许多应用程序,然而,它们仅限于向用户提供相关网站的查询列表。近年来,大语言模型(LLM)的成功为 BingChat、Google 的 SGE 和 Perplexity.ai 等更先进的系统铺平了道路。我们将这些新时代的系统称为生成引擎(GE),因为它们不仅能够搜索信息,还会通过合成多个来源生成多模态响应。从技术角度看,生成引擎涉及从数据库(如互联网)检索相关文档,并使用大型神经网络模型生成基于来源的回复,以确保信息的准确性和用户对其可验证性。

生成引擎对开发者和用户的实用性显而易见。用户能够更迅速、更准确地获取信息,同时开发者可以生成精确且个性化的响应,从而提高用户满意度和收益。但是,生成引擎将第三方利益相关者,包括网站和内容创作者置于不利地位。与传统搜索引擎相比,生成引擎通过直接提供准确而全面的响应,消除了导航到网站的必要性。由于数百万小型企业和个体经营者依赖在线流量和可见行盈利,生成引擎可能对他们的收入造成显著影响。此外,生成引擎的黑盒和特有性质使得内容创作者难以控制和理解生成引擎究竟是如何提取并呈现他们的内容。在这项工作中,我们迈出了朝着以创作者为中心的通用框架的第一步,即生成引擎优化(GEO)这将为内容创作者提供更大的信心,使其能够应对这一新的搜索范式。

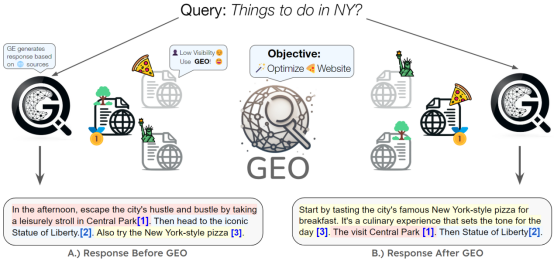

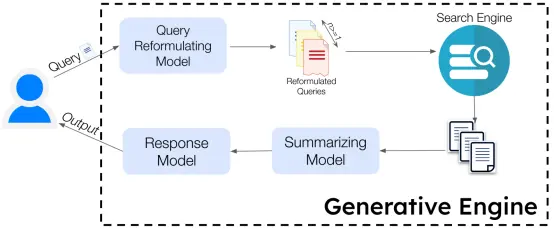

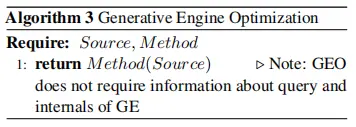

GEO 是一个旨在优化专有或闭源生成引擎(图 1)上网站内容可见性而设计的黑盒优化框架。生成引擎优化通过提取源网站输出一个优化的网站版本,调整内容的呈现方式、文本风格和内容,以增加在生成引擎中的可见性。

图 1:我们提出的 GENERATIVE ENGINE OPTIMIZATION(GEO)方法通过优化网站来提高它们在生成引擎响应中的可见性。GEO 的黑盒优化框架随后帮助原本可见性较差的披萨网站所有者优化他们的网站,从而在生成引擎下提高可见性。此外,GEO 的通用框架允许内容创作者定义和优化他们的自定义可见性指标,在这一新兴范式中赋予他们更大的控制权。

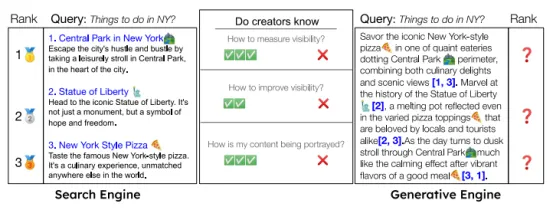

然而,值得注意的是,在生成引擎中,可见性的概念非常微妙且涉及多方面(图 3)。在传统搜索引擎中,平均排名是衡量可见性的一个良好指标,因为这些引擎呈现了网站的线性列表。然而,对于生成引擎而言,这种衡量方式并不适用。生成引擎提供了丰富且高度结构化的响应,将网站以内联引用的形式嵌入响应中,通常以不同的长度、在不同的位置和以多种不同的风格。因此,为生成引擎量身定制的可见性度量标准变得至关重要。在评估来源的可见性时,我们采用了一系列度量标准,综合考虑了多个方面,其中包括引用对查询的相关性和影响。评估过程涵盖了客观和主观的视角,以确保全面、准确地了解来源在各个维度上的可见性。我们的 GEO 框架引入了一套全面的可见性度量标准,使内容创作者能够定制适合自己的可见性度量标准。

为了在这一新的范式中对 GEO 方法进行忠实而全面的评估。我们提出了 GEO-BENCH,这是一个由来自多个领域和来源的 10,000 个查询组成的基准,专门为生成引擎进行了调整。通过系统评估,我们发现我们所提出的生成引擎优化方法能够在各种查询中将可见性提高 40%,为内容创作者提供了在迅速变化的生成引擎环境中改善可见性的有效策略。我们的研究发现,通过引用、引述相关来源的语句以及加入统计数据,能够显著提高来源的可见性,其中各种查询的提高幅度超过 40%。此外,我们还观察到生成引擎优化方法的有效性与查询所属的领域存在关联。

总体而言,我们的研究在三个方面做出了贡献:(1)我们引入了生成引擎优化,这是为网站所有者提供的首个通用框架,以更好地适应生成引擎的新时代。(2)我们的框架提出了一套专为生成式引擎设计的综合可见性指标,并使内容创作者能够制定符合自身需求的可见性度量标准。(3)为了促进对生成引擎优化方法的准确评估,我们提出了第一个大规模基准,包括来自不同领域和数据集的多样化查询,专门为生成引擎进行了定制。

2 构建与方法论

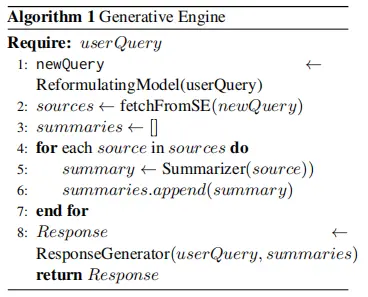

2.1 生成引擎的构建与设计尽管已将众多生成引擎部署给数百万用户,但目前尚未建立标准框架。我们提供了一个标准框架,适用于设计中包含的各种模块组件。

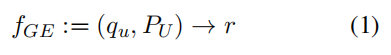

我们介绍了一种生成引擎,它由多个后端生成模型和一个用于源检索的搜索引擎组成。生成引擎(GE)的输入是用户查询qu,输出是自然语言响应r,其中PU表示个性化用户信息,包括偏好和历史。生成引擎可以被表示为一个函数:

尽管响应 r 可能具有多种模态,但在本节中,我们将其简化为文本形式的响应。

生成引擎由两个关键组件组成:a) 一组生成模型G= {G1, G2…Gn},每个模型都有特定的用途,例如查询重构或摘要;b) 一个搜索引擎SE,在给定查询q的情况下返回一组源S= {s1, s2…sm}。在图 2 中,我们展示了一个典型的工作流程,该流程在设计时与 BingChat 相似。查询重构生成模型G1=Gqr生成一组查询Q1= {q1, q2…qn},随后将这些查询传递给搜索引擎SE以检索一组排名的源S= {s1, s2, …, sm}。源集S传递给摘要模型G2=Gsum,该模型为S中的每个源生成摘要Sumj,形成摘要集合(Sum= {Sum1, Sum2, …, Summ})。摘要集传递给响应生成模型G3=Gresp,生成由源S支持的累积响应r。我们建议读者参考算法 1,其中提供了描述生成引擎工作的代表性伪代码。在本研究中,我们关注单轮生成引擎,但该框架可以轻松扩展到多轮生成引擎。

图 2:生成引擎概览。生成引擎主要由一组生成模型和一个搜索引擎组成。用户查询作为输入,经过一系列步骤生成最终响应,该响应基于检索到的来源,包含整个响应中的内联属性。

响应r通常是一篇嵌入了引用信息的结构化的文本回复。鉴于语言模型有产生虚构信息的倾向(Ji et al., 2023),引文的嵌入在文本中显得尤为重要。具体而言,考虑一个由句子{l1, l2…lo}构成的响应r。每个句子可能由一组引文支持,这些引文是检索到的文档集合Ci⊂ S的一部分。理想的生成引擎应确保响应中的所有陈述都得到相关引文的支持(高引文召回率),并且所有引文准确支持它们所关联的陈述(高引文精确率)(Liu et al., 2023a)。

2.2 生成引擎的优化

搜索引擎的兴起促进了搜索引擎优化(SEO)的发展,这是一种帮助网站创建者优化其内容以提高在搜索引擎结果页面(SERP)中排名的过程。更高的排名与更广泛的可见性以及网站流量的提升呈正相关。然而,随着生成引擎成为信息传递范式中的核心,SEO 并不直接适用于它,因此需要开发新的技术。

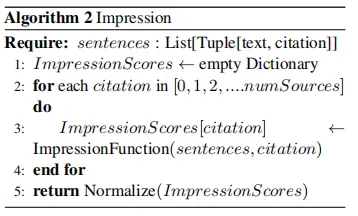

为了实现这一目标,我们提出了生成引擎优化(GEO),这是一个新的范式,其中内容创作者的目标是提高他们在生成的响应中的可见性。我们通过函数 Impwc(ci,r) 定义了在生成引擎中引用响应r中网站/引文ci的可见性,而网站创建者希望最大化这一可见性。与此同时,从生成引擎的角度来看,目标是最大化 εiImpwc(ci, r)· Rel(ci,q,r) 的乘积),其中Rel(ci, q, r)表示在响应r的上下文中引文ci对查询q的相关性的度量。然而,对于生成引擎而言,函数g和Rel目前还没有明确定义,我们会在下文中对其进行定义。

图 3:在传统搜索引擎中,排名和可见性指标相当直观,按照逐字内容的排名顺序列出网站来源。然而,生成引擎产生的响应更为丰富且结构化,通常将引文嵌入到一个单一的块中,并以交替的方式排列。这使得排名和可见性的概念变得比较微妙。此外,与那些专注于在搜索引擎上改善网站可见性的研究不同,如何优化生成引擎响应中的可见性仍然不太清楚。为了解决这些挑战,我们的黑匣子优化框架提出了一系列精心设计的可见性度量,创作者可以用来衡量和优化他们的网站,并允许创作者定义他们自己的可见性度量。

2.2.1 生成引擎的可见性

在 SEO 领域中,网站的可见性主要由其在实际搜索中的平均排名来衡量。然而,由于生成引擎输出的特性与传统搜索引擎有所不同,可见性的度量尚未得到明确定义。生成引擎在单个响应中整合了来自多个信息源的数据,与传统搜索引擎不同。因此,影响引文真实可见性的因素包括长度、独特性以及引文网站的呈现方式等。在本段中,我们会交替使用“网站”和“引文”这两个术语。

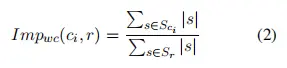

为了解决这个问题,我们制定了多个可见性度量标准。其中,“字数”度量标准是引文相关句子的标准化字数。在数学上,这被定义为:

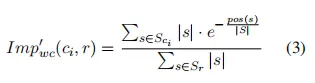

在这个背景下,Sci表示引用集合ci中的句子,Sr表示响应中的句子集合,而|s|表示句子s中的词数。对于被多个源引用的句子,我们简单地共享其包含的词数。较多的词数通常与源在回答中的重要性相关,因此用户更容易接触到该源的信息。然而,由于“词数”不受引文排名的影响(例如,它是否首次出现),我们引入了一个位置调整计数,通过引文排名的指数衰减函数来减小权重:

上述的可见性度量的标准是客观而有力的。然而,它们忽略了引文对用户注意力的主观影响。为了解决这一问题,我们引入了“主观可见性”度量标准,该标准涵盖多个方面,包括:1. 引文材料与用户查询的相关性。2. 引文的影响力,评估生成响应在多大程度上依赖于引文。3. 引文呈现的材料的独特性。4. 主观位置度量源在用户视角下的显著性。5. 主观计数度量用户在阅读引文时感知到的内容量。6. 点击引文的概率。7. 呈现材料的多样性。为了测量这些子度量标准,我们采用了 G-Eval(Liu et al., 2023b),这是当前 LLM 评估领域的最新技术。

2.2.2 针对网站的生成引擎优化方法

为了提升可见性度量标准,内容创作者需要对其网站进行调整。为此,我们提出了几种与生成引擎无关的策略,这些策略被称为生成引擎优化方法(GEO)。在数学上,每个 GEO 方法都可以看作是一个函数f:W→W′i,其中W代表初始的网站内容,而W′表示经过应用 GEO 方法后修改的网站内容。设计良好的 GEO 方法应该有助于提升网站的可见性。这些方法的目标是以一种独立于查询的方式修改网站内容W,涵盖的范围从简单的风格变化到以结构化方式合并新内容。

为了提升可见性度量标准,内容创作者需要对其网站进行调整。我们提出了一系列方法,包括:1. 权威性(Authoritative):修改源内容的文本风格,使其更富有说服力,并提出更具权威性的主张;2. 关键词堆砌(Keyword Stuffing):修改内容以包含更多来自查询的关键词,类似传统SEO优化;3. 统计数据添加(Statistics Addition):修改内容以包含定量统计数据,而不是定性讨论,尽可能地添加;4. 引用来源(Cite Sources)和5. 引文添加(Quotation Addition):添加相关的引文和引用来自可信来源;6. 简单易懂:简化网站语言;7. 流畅度优化(Fluency Optimization):提高文本流畅度;8. 独特词汇(Unique Words)和9. 专业术语(Technical Terms):在可能的地方分别添加独特和专业术语。除了方法 3、4 和 5 外,其余方法不需要向网站添加新内容。相反,这些方法主要侧重于以提高现有内容的表达方式为主,使其更具说服力或更吸引生成引擎。这些生成引擎优化方法可分为两大类:内容添加和风格优化。在实际应用中,这些生成引擎优化方法将由网站所有者根据这些原则修改其文本。然而,为了我们的实验目的,我们通过为 GPT-3.5 模型创建适当的提示来实现生成引擎优化方法,以将源文本转换为修改后的文本。

为了评估我们方法的性能提升,我们针对每个输入查询随机选择了一种生成引擎优化(GEO)方法进行源的优化。为了降低统计噪声,我们对每种方法的每个查询生成了 5 个答案。

3 实验设置

3.1 评估生成引擎

我们采用了两步法设计生成引擎。首先,获取输入查询的相关来源,然后由 LLM 根据这些来源生成响应。在我们的设置中,我们从谷歌搜索引擎中每次获取前 5 个与查询相关的来源。生成的答案由 gpt3.5-turbo 模型生成,使用的提示与之前的工作相同(Liu et al., 2023a)。

3.2 基准

鉴于目前尚无包含生成引擎相关查询的公开可用数据集,我们特别创建了名为 GEO-BENCH 的基准。该基准包含了 10,000 个查询,涵盖了多个不同来源,专门用于生成引擎的评估,同时包括合成生成的查询。这个基准涵盖了来自九个不同来源的查询,每个查询都经过了详细的分类,包括目标领域、难度、查询意图以及其他维度。

用于构建基准的数据集如下:

1. MS Macro,2. ORCAS-1 和 3. Natural Questions(Kwiatkowski et al., 2019; Alexander et al., 2022; Craswell et al., 2021)。这三个数据集包含来自 Bing 和Google 搜索引擎的真实匿名用户查询,是搜索引擎相关研究中常用的代表性数据集。然而,生成引擎面临更加困难和具体的查询,其目的是从多个数据源合成答案,而不是简单地搜索它们。为了更全面地评估生成引擎的性能,我们还使用了其他几个公开可用的数据集:4. AllSouls:包含来自牛津大学”All Souls College”的论文问题。这个数据集中的查询要求生成引擎进行适当的推理,从多个源中聚合信息。5. LIMA:包含具有挑战性的问题,要求生成引擎不仅要聚合信息,还要进行适当的推理来回答问题,例如:写一首简短的诗,编写Python代码。6. Davinci-Debate(Liu et al., 2023a):包含用于测试生成引擎的辩论问题。7. Perplexity.ai Discover:包含了来自该平台上热门查询的更新列表。8. ELI-5:这个数据集包含来自 ELI5 subreddit 的问题,用户在其中提出复杂的问题,并期望用简单的术语得到答案。9. GPT-4 生成的查询:为了增加查询分布的多样性,我们引导 GPT-4 生成各种领域(例如:科学、历史)的查询,并基于查询意图(例如:导航性、交易性)以及生成的响应的难度和范围(例如:开放式、基于事实)。

我们的基准包含 10,000 个查询,划分为训练集(8,000 个)、验证集(1,000 个)和测试集(1,000 个)。每个查询都经过 GPT-4 的标注,以便衡量各种维度,包括意图、难度、查询领域和答案类型的格式。我们保持了真实世界查询的分布,确保基准包含 80% 的信息性查询,以及 10% 的交易性查询和 10% 的导航性查询。为了增强每个查询,我们使用来自 Google 搜索引擎的前 5 个搜索结果的清理文本内容。我们将 GEO-BENCH 视为评估生成引擎综合性能的基准。该基准将在当前及未来的工作中充当评估生成引擎多个目的的标准测试平台。

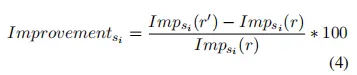

3.3 评估指标我们通过计算可见性相对改善来评估所有的方法。对于来自源集合Si∈ {s1, . . . , sm} 的初始生成响应r和经过修改后的响应r’,我们测量每个源si的可见性相对改善,具体计算方式为:

修改后的响应r’是通过将要评估的生成引擎优化方法应用于源si而生成的。要优化的源si是随机选择的,但在所有生成引擎优化方法中对于特定查询保持一致。

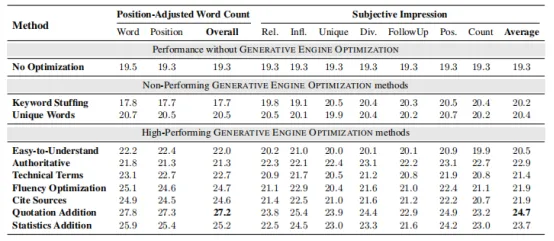

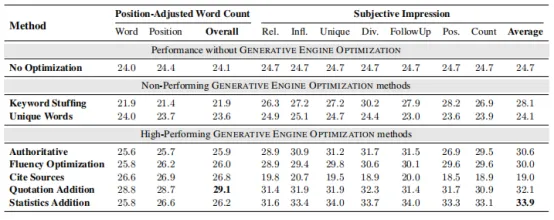

表 1:GEO 方法在 GEO-BENCH 上的性能提升。我们对两个指标及其子指标进行了性能测量。与传统 SEO 中常用的简单方法,如关键词堆砌相比,我们的方法表现不佳。然而,我们提出的方法,如统计添加和引文添加,在所有考虑的指标上都展现出强大的性能改进。性能最佳的方法使位置调整的字数和主观可见性分别提高了 41% 和 29%。为提高可读性,我们对主观可见性分数相对于位置调整的字数进行了归一化,这导致基线分数在各指标上相似。

4 结果

我们对各种生成引擎优化方法进行了评估,每一种方法都旨在通过优化网站内容来提高在生成引擎响应中的可见性。我们将这些方法与未应用任何优化的基准情况进行了比较。我们的评估在 GEO-BENCH 上进行,这是一个包含多个领域和设置的多样化基准,其中包含各种用户查询。我们采用了两个不同的指标来评估这些方法的性能:位置调整的字数(PositionAdjusted Word Count)和主观可见性(Subjective Impression)。位置调整的字数指标考虑了引文在生成引擎响应中的字数和位置,而主观可见性指标结合了多个主观因素,计算得出一个整体可见性分数。

我们的研究结果详见表 1,该结果清晰展示了我们的生成引擎优化方法在 GEO-BENCH 上在所有指标上均表现优于基线。这表明这些方法在处理不同查询时表现出很强的鲁棒性,因为它们能够在查询的多样性情况下取得显著的改进。具体而言,我们观察到最佳表现的方法包括引用来源、引文添加和统计添加,与基线相比,在位置调整的字数指标上相对改善了 30-40%,在主观可见性指标上相对改善了 15-30%。

这些方法涉及在网站内容中添加相关统计信息(统计添加)、整合可信引语(引语添加)和包含来自可靠来源的引文(引文来源),对实际内容本身需要进行最少的更改。然而,它们在生成引擎的响应中显著提高了网站可见性,提升了内容的可信度和丰富性。

有趣的是,诸如改善源文本的流畅性和可读性的风格变化,即“流畅性优化”和“易于理解”的方法,也提升了 15-30% 的可见性。这表明生成引擎不仅注重内容,还注重信息的呈现。

此外,鉴于生成引擎中使用的生成模型通常是按照指令设计的,人们可能会期望网站内容中更具说服力和权威性的语调能够提高可见性。然而,相反地,我们并未观察到显著的改善,这表明生成引擎对于这些变化已经相当鲁棒。因此,网站所有者更应该集中精力改善内容的呈现方式,使其更具可信度。

最后,我们还评估了使用关键词堆砌的策略,即在网站内容中添加更多相关关键词。尽管这种技术在搜索引擎优化中被广泛使用,但我们发现这些方法对生成引擎的响应几乎没有性能提升。这强调了网站所有者有必要重新考虑针对生成引擎的优化策略,因为对于在传统 SEO 中有效的技术不一定会在新的范式中取得成功。

5 分析

5.1 特定领域的生成引擎优化

在第 4 节中,我们介绍了通过生成引擎优化在整个 GEO-BENCH 基准上的改进。然而,值得注意的是,在实际的 SEO 场景中,通常会对网站进行特定领域的优化。考虑到这一点以及我们在 GEO-BENCH 中为每个查询提供了类别,我们深入研究了各种 GEO 方法在这些类别中的表现。

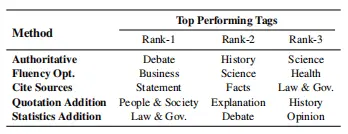

表 2:每种生成引擎优化方法的最佳执行类别。网站所有者可以根据其目标领域选择相关的 GEO 策略。

表 2 详细展示了我们的 GEO 方法在哪些类别中表现最为出色。对这些结果进行仔细分析揭示了一些引人注目的观察。例如,从权威性的角度来看,在辩论性问题和与“历史”领域相关的查询中显著提高了性能。这一发现与我们的直觉一致,因为在辩论性语境中,一种更具有说服力的写作形式可能更有价值。同样地,通过引用来源进行引文添加对于事实性问题尤其有益。因为引文提供了事实的验证来源,从而增强了响应的可信度。GEO 方法在不同领域的有效性各有差异。例如,正如表 2 的第 5 行所示,涉及‘法律与政府’等领域和涉及‘意见’等问题类型会显著受益于在网站内容中添加相关统计数据,而这一操作是由“统计添加”方法实现的。这说明在特定上下文中,将数据驱动的证据纳入其中可以特别增强网站的可见性。在‘人与社会’、‘解释’和‘历史’领域中,采用“引语添加”方法效果最为显著。这可能是因为这些领域经常涉及个人叙述或历史事件,直接引用可以为内容注入真实性和深度。

综上所述,我们的分析表明,站点所有者应该努力对特定领域进行有针对性的调整,以提高网站的可见性。

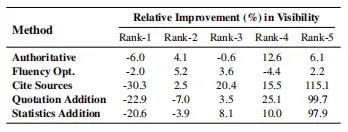

5.2 同时优化多个网站

在生成引擎不断发展的背景下,GEO 方法预计将被广泛采用,从而导致所有来源内容都将使用 GEO 进行优化。为了了解这种情况所造成的影响,我们对同时优化所有来源内容的生成引擎优化方法进行了评估(评估结果详见表 3)。我们得出的一个重要结论是,根据网站在搜索引擎结果页面(SERP)中的排名,GEO 对网站的影响有所不同。有趣的是,在 SERP 中排名较低的网站通常很难获得可见性,但它们从 GEO 中获得的好处却明显多于排名较高的网站。这一点从表 3 中显示的可见性相对提高情况中可见一斑。例如,Cite Sources 方法使 SERP 排名第五的网站的可见性大幅提高了 115.1%,而排名第一的网站的可见性平均下降了 30.3%。

表 3:通过 GEO 方法在搜索引擎中不同排名的来源的可见性变化。

对于在搜索引擎排名较低的网站,GEO 方法尤其有帮助。这一发现突显了将 GEO 作为数字空间民主化工具的潜力。值得注意的是,许多排名较低的网站通常由小型内容创作者或独立企业创建,他们在与占据搜索引擎结果排名前列的大型企业竞争时一直面临巨大挑战。生成引擎的出现最初似乎对这些小型实体不利。然而,GEO 方法的应用为这些小型内容创作者提供了一个机会,可以显著提升他们在生成引擎响应中的可见性。通过利用 GEO 增强他们的内容,他们能够触及更广泛的受众,从而创造出一个公平的竞争环境,使他们能够在数字空间更有效地与大型企业竞争。

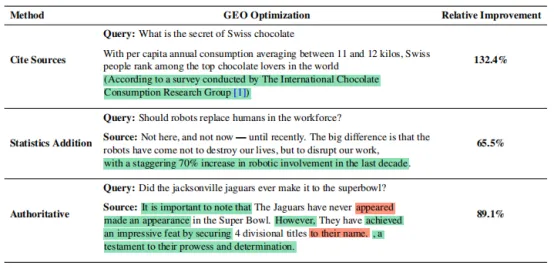

5.3 定性分析

我们在表 4 中对 GEO 方法进行了定性分析。该分析包含一些具有代表性的例子,在这些例子中,GEO 方法在极少调整的情况下提高了原文的可见性。在这三种方法中,每种方法都通过在文本中进行适当的增删来优化来源。在第一个例子中,我们可以看到,只需在文本中添加陈述的来源,就能在最终答案中显著提高可见性,而这几乎不需要内容创作者付出太多努力。第二个例子表明,尽可能地添加相关统计数据,可以使来源更容易被注意到。最后,第三个例子表明,仅仅强调文本的部分内容并采用更具说服力的写作风格,也能在可见性方面取得相当大的改善。

表 4:GEO 方法优化源网站的代表性例子。添加内容用绿色标记,删除内容用红色标记。在内容中没有添加任何实质性的新信息的情况下,GEO 方法能够显著增加源内容的可见性。

6 GEO实战:在实际场景中的实验

为了进一步验证我们提出的生成引擎优化方法的有效性,我们在 Perplexity.ai 上对这些方法进行了评估。Perplexity.ai 是一个已部署的生成引擎,拥有庞大的用户群体。由于 Perplexity.ai 不允许用户指定源 URL,因此我们将源文本以文件形式上传到 Perplexity.ai,以确保所有生成的答案仅使用提供的文件源。我们在包含 200 个样本的测试集子集上评估了所有方法,Perplexity.ai 上的结果如表 5 所示。我们发现,与我们的生成引擎类似,引用添加方法在 Position-Adjusted Word Count 方面表现最佳,相对于基准的改进达到了 22%。此外,在我们的生成引擎中表现良好的方法,如引用来源和统计数据添加,在这两个指标上分别显示出了显著的改进,分别为 9% 和 37%。值得注意的是,传统的 SEO 方法,如关键词堆砌,在这些指标上的表现比基准差 10%。这一结果强调了开发不同 GEO 方法以造福内容创作者的重要性,并更进一步突显了我们提出的简单实施方法可以直接被内容创作者采纳,从而产生实际可见的积极效果。

表 5 显示了 GEO 方法在 GEO-BENCH 上通过 Perplexity.ai 作为生成引擎的性能提升。与传统 SEO 中常用的关键词堆砌等简单方法相比,它们通常表现为负面性能。相反,我们提出的方法,如统计添加和引文添加,在考虑的所有指标上都表现出强烈的性能改进。最佳性能的方法在位置调整的字数上提高了 22%,在主观可见性上提高了 37%。这些分数直接展示了我们提出的方法对已部署的生成引擎所产生的高影响。

7 相关工作

- 基于证据的答案生成:先前的研究采用了多种技术来生成经相关来源支持的答案。训练GPT-3模型通过文本命令浏览基于网络的环境,以回答有来源支撑的问题。同样,其他方法(Shusteret al.,2022;Thoppilan et al.,2022;Menick et al.,2022)也是通过搜索引擎获取相关来源,并利用它们生成答案。我们的目标是整合所有这些方法,并为将来改进这些系统提供一个共同的评估基准。

- 检索增强语言模型:最近有几项研究通过从知识库中获取相关资源来完成任务,从而解决了语言模型内存有限的问题(Asaiet al.,2021;Mialonet al.,2023;Guuet al.,2020)。然而,对于生成型引擎而言,其任务不仅仅是生成答案,还需要在生成的答案中提供详细的归因。此外,就输入和输出而言,生成引擎并非仅限于单一模式的文本。更进一步地说,生成引擎的框架涉及多种任务,包括但不限于查询重构、来源选择以及决定如何以及何时执行这些任务。

- 搜索引擎优化:在过去的近 25 年里,大量的公共和私人研究已经致力于优化网页内容以适应搜索引擎的要求(Ankalkoti,2017;Shahzad 等,2020;Kumar 等,2019)。这些研究通常分为两类:页面内搜索引擎优化(On-Page SEO)和页面外搜索引擎优化(Off-Page SEO)。前者主要关注于改进网站实际内容,优化用户体验和可访问性;而后者涉及通过链接建设和识别提高网站的权威性和声誉。相较之下,GEO 所处理的环境更为复杂,涉及多模态和会话设置。由于GEO是基于生成模型进行优化的,不仅仅局限于简单的关键词匹配,因此传统的搜索引擎优化策略并不适用于生成引擎的设置。这凸显了对 GEO 的迫切需求。

8 结论

在这项研究中,我们将新时代的搜索引擎称为生成式引擎,并提出了生成式引擎优化(GEO)的概念,旨在帮助内容创作者掌握优化其内容的权力。我们为生成引擎定义了曝光度量指标,并制定了一个基准,该基准包括来自多个领域和环境的各种用户查询,以及回答这些查询所需的相关来源。为了优化生成式引擎的内容,我们提出了多种方法,并成功证明这些方法能够在生成引擎响应中将来源的可见性提高多达 40%。我们的研究发现:包含引文、相关来源的引语和统计数据可以显著提高来源的可见性。此外,我们还发现 GENERATIVE ENGINE OPTIMIZATION 方法的有效性与查询的领域有关。这一研究为深入了解生成引擎对数字空间的影响以及 GENERATIVE ENGINE OPTIMIZATION 在搜索引擎新时代的作用迈出了重要一步。

伦理考虑和可重复性声明

在我们的研究中,我们专注于提高生成引擎中网站的可见性,而不直接与敏感数据或个体互动。尽管我们从搜索引擎检索的来源可能包含偏见或不适当的内容,但这些内容已经是公开可访问的。我们强调,我们的研究既不放大也不认可这些内容。从伦理角度看,我们认为我们的工作是合理的,因为它主要处理公开可获取的信息,旨在提高生成引擎中的用户体验。

为确保可重复性,我们已经分享了我们的代码,使其他人能够复制我们的结果。值得注意的是,我们的主要实验采用了五个不同的种子,以减小潜在的统计偏差。

参考

- Daria Alexander, Wojciech Kusa, and Arjen P. de Vries. 2022. Orcas-i:Queries annotated with intent using weak supervision. Proceedings of the 45th International ACM SIGIR Conference on Research and Development in Information Retrieval.

- Prashant Ankalkoti. 2017. Survey on search engine optimization tools & techniques. Imperial journal of interdisciplinary research, 3.

- Akari Asai, Xinyan Velocity Yu, Jungo Kasai, and Hannaneh Hajishirzi. 2021. One question answering model for many languages with cross-lingual dense passage retrieval. In Neural Information Processing Systems.

- Sihao Chen, Daniel Khashabi, Wenpeng Yin, Chris Callison-Burch, and Dan Roth. 2019. Seeing things from a different angle:discovering diverse perspectives about claims. In North American Chapter of the Association for Computational Linguistics.

- Nick Craswell, Bhaskar Mitra, Emine Yilmaz, Daniel Fernando Campos, and Jimmy J. Lin. 2021. Ms marco:Benchmarking ranking models in the large-data regime. Proceedings of the 44th International ACM SIGIR Conference on Research and Development in Information Retrieval.

- Kelvin Guu, Kenton Lee, Zora Tung, Panupong Pasupat, and Ming-Wei Chang. 2020. Realm:Retrievalaugmented language model pre-training. ArXiv, abs/2002.08909.

- Bernard Jim Jansen, Danielle L. Booth, and Amanda Spink. 2008. Determining the informational, navigational, and transactional intent of web queries. Inf. Process. Manag., 44:1251–1266.

- Ziwei Ji, Nayeon Lee, Rita Frieske, Tiezheng Yu, Dan Su, Yan Xu, Etsuko Ishii, Ye Jin Bang, Andrea Madotto, and Pascale Fung. 2023. Survey of hallucination in natural language generation. ACM Computing Surveys, 55(12):1–38.

- R. Anil Kumar, Zaiduddin Shaik, and Mohammed Furqan. 2019. A survey on search engine optimization techniques. International Journal of P2P Network Trends and Technology.

- Tom Kwiatkowski, Jennimaria Palomaki, Olivia Redfield, Michael Collins, Ankur P. Parikh, Chris Alberti, Danielle Epstein, Illia Polosukhin, Jacob Devlin, Kenton Lee, Kristina Toutanova, Llion Jones, Matthew Kelcey, Ming-Wei Chang, Andrew M. Dai, Jakob Uszkoreit, Quoc V. Le, and Slav Petrov. 2019. Natural questions:A benchmark for question answering research. Transactions of the Association for Computational Linguistics, 7:453–466.

- Nelson F. Liu, Tianyi Zhang, and Percy Liang. 2023a. Evaluating verifiability in generative search engines. ArXiv, abs/2304.09848.

- Yang Liu, Dan Iter, Yichong Xu, Shuo Wang, Ruochen Xu, and Chenguang Zhu. 2023b. G-eval:Nlg evaluation using gpt-4 with better human alignment. ArXiv, abs/2303.16634.

- Jacob Menick, Maja Trebacz, Vladimir Mikulik, John Aslanides, Francis Song, Martin Chadwick, Mia Glaese, Susannah Young, Lucy CampbellGillingham, Geoffrey Irving, and Nathan McAleese. 2022. Teaching language models to support answers with verified quotes. ArXiv, abs/2203.11147.

- Grégoire Mialon, Roberto Dessì, Maria Lomeli, Christoforos Nalmpantis, Ramakanth Pasunuru, Roberta Raileanu, Baptiste Rozière, Timo Schick, Jane Dwivedi-Yu, Asli Celikyilmaz, Edouard Grave, Yann LeCun, and Thomas Scialom. 2023. Augmented language models:a survey. ArXiv, abs/2302.07842.

- Reiichiro Nakano, Jacob Hilton, S. Arun Balaji, Jeff Wu, Ouyang Long, Christina Kim, Christopher Hesse, Shantanu Jain, Vineet Kosaraju, William Saunders, Xu Jiang, Karl Cobbe, Tyna Eloundou, Gretchen Krueger, Kevin Button, Matthew Knight, Benjamin Chess, and John Schulman. 2021. Webgpt:Browserassisted question-answering with human feedback. ArXiv, abs/2112.09332.

- A. Shahzad, Deden Witarsyah Jacob, Nazri M. Nawi, Hairulnizam Bin Mahdin, and Marheni Eka Saputri. 2020. The new trend for search engine optimization, tools and techniques. Indonesian Journal of Electrical Engineering and Computer Science, 18:1568.

- Kurt Shuster, Jing Xu, Mojtaba Komeili, Da Ju, Eric Michael Smith, Stephen Roller, Megan Ung, Moya Chen, Kushal Arora, Joshua Lane, Morteza Behrooz, W.K.F. Ngan, Spencer Poff, Naman Goyal, Arthur Szlam, Y-Lan Boureau, Melanie Kambadur, and Jason Weston. 2022. Blenderbot 3:a deployed conversational agent that continually learns to responsibly engage. ArXiv, abs/2208.03188.

- Romal Thoppilan, Daniel De Freitas, Jamie Hall, Noam M. Shazeer, Apoorv Kulshreshtha, Heng-Tze Cheng, Alicia Jin, Taylor Bos, Leslie Baker, Yu Du, Yaguang Li, Hongrae Lee, Huaixiu Steven Zheng, Amin Ghafouri, Marcelo Menegali, Yanping Huang, Maxim Krikun, Dmitry Lepikhin, James Qin, Dehao Chen, Yuanzhong Xu, Zhifeng Chen, Adam Roberts, Maarten Bosma, Yanqi Zhou, Chung-Ching Chang, I. A. Krivokon, Willard James Rusch, Marc Pickett, Kathleen S. Meier-Hellstern, Meredith Ringel Morris, Tulsee Doshi, Renelito Delos Santos, Toju Duke, Johnny Hartz Søraker, Ben Zevenbergen, Vinodkumar Prabhakaran, Mark Díaz, Ben Hutchinson, Kristen Olson, Alejandra Molina, Erin HoffmanJohn, Josh Lee, Lora Aroyo, Ravindran Rajakumar, Alena Butryna, Matthew Lamm, V. O. Kuzmina, Joseph Fenton, Aaron Cohen, Rachel Bernstein, Ray Kurzweil, Blaise Aguera-Arcas, Claire Cui, Marian Rogers Croak, Ed Huai hsin Chi, and Quoc Le. 2022. Lamda:Language models for dialog applications. ArXiv, abs/2201.08239.

- Chunting Zhou, Pengfei Liu, Puxin Xu, Srini Iyer, Jiao Sun, Yuning Mao, Xuezhe Ma, Avia Efrat, Ping Yu, L. Yu, Susan Zhang, Gargi Ghosh, Mike Lewis, Luke Zettlemoyer, and Omer Levy. 2023. Lima:Less is more for alignment. ArXiv, abs/2305.11206.

*以上文章翻译自《GEO: Generative Engine Optimization》,如需原文,请与我们联系。

WF Research 是以第一性原理为基础的专业顾问服务机构,欢迎关注和留言!

微信:Alexqjl